O rewolucji w dubbingu mówi się już od jakiegoś czasu. Powszechność sztucznej inteligencji, która zmodyfikuje ruch ust aktorów w taki sposób, by wypowiadane kwestie stały się bardziej naturalne, przepowiada się od kilku lat. Najnowsze, imponujące rozwiązania zebrano w oprogramowaniu Flawless AI, choć do przekształcenia obecnego stanu rzeczy może przyczynić się też nowe osiągnięcie polskich inżynierów.

Dubbing pozostaje popularną (a w niektórych krajach, jak np. Niemcy, Francja, Hiszpania, Włochy, Brazylia czy Węgry - najpopularniejszą) formą opracowań zagranicznych filmów na inne języki. Sztuka dubbingu ma wielu przeciwników, jednak spora część widzów jest do niego tak bardzo przyzwyczajona, że nie wyobraża sobie konsumpcji wielu obrazów z - dajmy na to - napisami. To niełatwe zadanie: napisać dialogi tak, by w miarę możliwości jak najwierniej przełożyć oryginał, jednocześnie starając się dopasować kolejne słowa do ruchu ust aktorów. Rozjeżdżający się nieraz dubbing bywa problematyczny i irytujący, jednak twórcy algorytmów sztucznej inteligencji znaleźli na to sposób.

Koniec nierealnego dubbingu. Sztuczna inteligencja wkracza do akcji

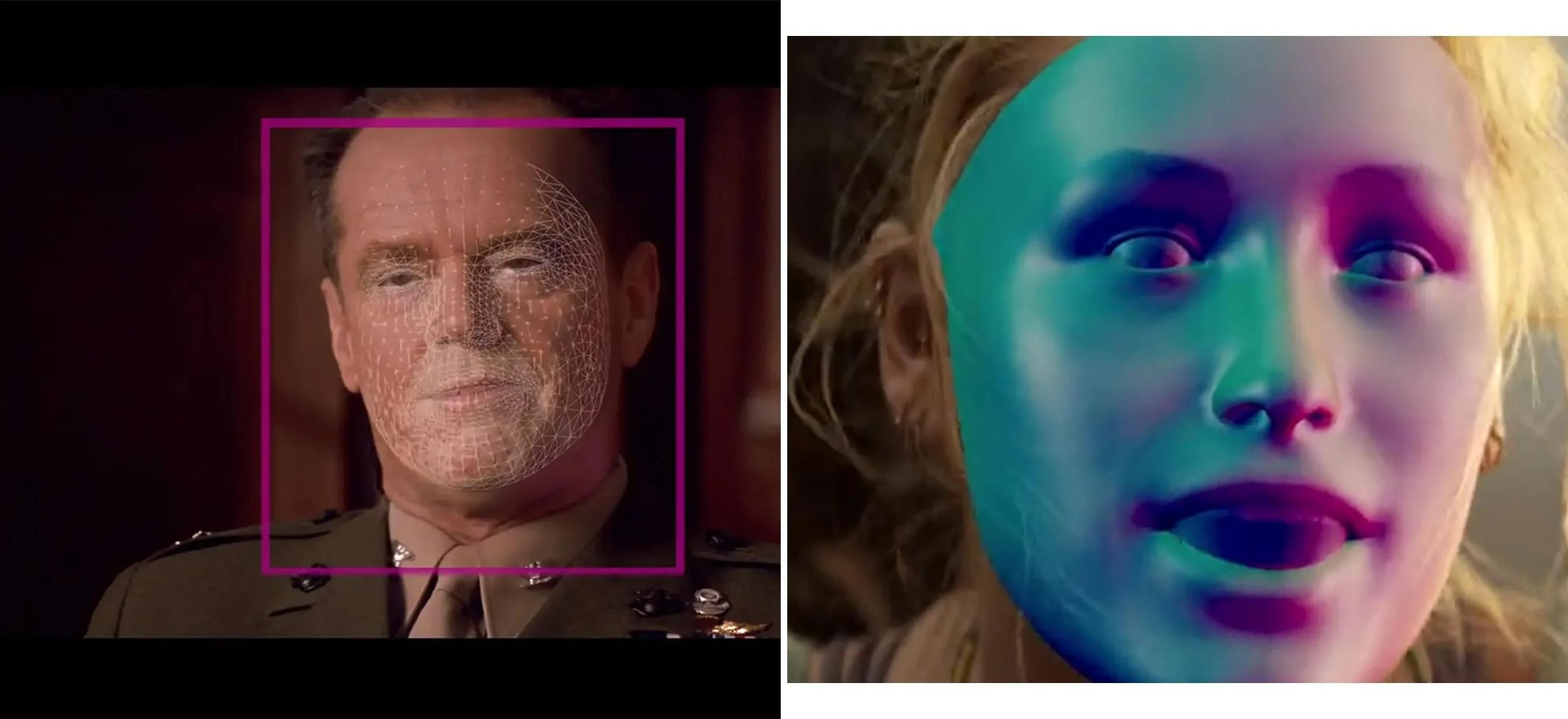

Mówiono o tym już kilka lat temu, ale teraz zapowiedzi stają się rzeczywistością. Technologia TrueSync, korzystająca z algorytmów AI (dzięki Flawless AI od Nicka Lynessa i Scotta Manna), może synchronizować ruch warg artystów z wypowiedziami nagranymi w zupełnie innym języku niż ten uwieczniony kamerą. Jak to działa? Model odnajduje właściwe ułożenie ust aktora, które jest przypisane do danego dźwięku emitowanego w filmie. Następnie kopiuje go w odpowiednie miejsce.

Cel jest oczywisty - uwiarygodnić dopasowanie obcej ścieżki dialogowej i poprawić wrażenia widzów. Co więcej, dzięki temu wynalazkowi skróci się czas nagrań - nierzadko zdarza się przecież, że trzeba je było wielokrotnie powtarzać w związku z nieodpowiednio zaakcentowanymi wypowiedziami w ramach całej sceny. Imponujący jest fakt, że zmiany w obrębie twarzy członków obsady są często niemal niezauważalne. Oczywiście, do doskonałości jeszcze trochę brakuje, ale... nie będzie trudno ją osiągnąć.

Warto też zwróci uwagę na startup technologii głosowej ElevenLabs, którego twórcami są polscy inżynierowie - Matki Staniszewski i Piotr Dąbkowski. Odpowiadają za projekt sztucznej inteligencji imitującej ludzki głos. Ich narzędzie ma nie tylko wytwarzać poszczególne frazy po wpisaniu tekstu, ale też stworzyć długie wypowiedzi w pełnej gamie emocji po usłyszeniu próbki danego głosu. Koncept może również ułatwić realizowanie audiobooków lub tłumaczenie wypowiedzi w czasie rzeczywistym.